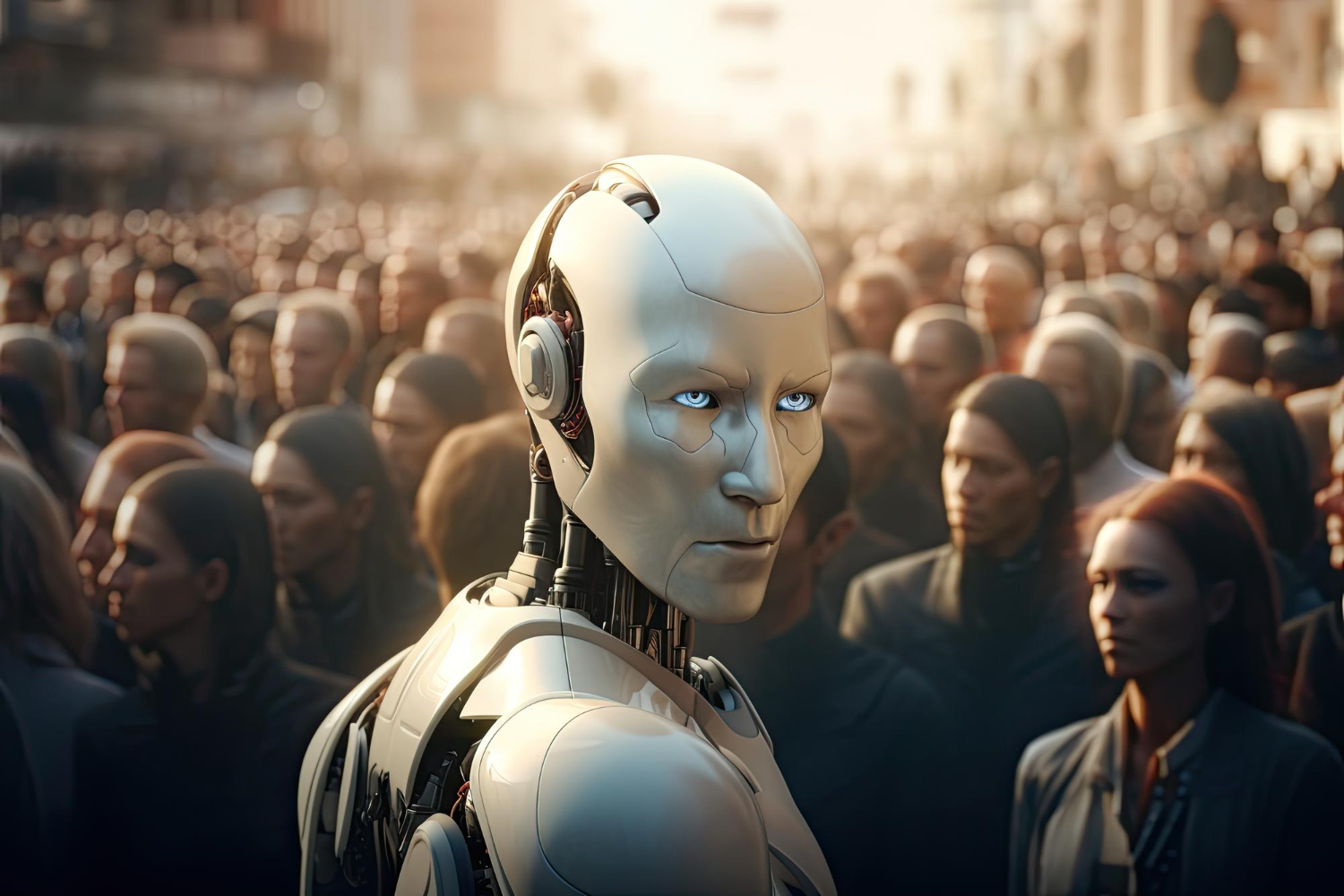

Novo estudo mostra que, por enquanto, a humanidade pode ficar tranquila: o risco de as máquinas se revoltarem é pequeno

As histórias de máquinas se rebelando contra seus criadores já se tornaram parte da nossa cultura popular. Filmes, livros e videogames abordam esse medo de forma recorrente. Mas será que a inteligência artificial pode realmente tomar consciência e sair do nosso controle?

Pesquisadores da Universidade Técnica de Darmstadt, na Alemanha, e da Universidade de Bath, no Reino Unido, foram à procura de uma resposta e observaram se modelos de linguagem grandes (LLMs – sigla em inglês) podem desenvolver habilidades para além de seu código. O resultado mostra que não precisamos ter medo por enquanto.

A IA pode se desenvolver de forma independente?

- Com o aumento do tamanho dos atuais modelos de linguagem, há o temor de que eles possam desenvolver habilidades perigosas, como raciocínio e planejamento.

- Nos testes, os pesquisadores analisaram quatro modelos de LLMs que desenvolveram tarefas emergentes, ou seja, para as quais não foram explicitamente treinados.

- Eles não encontraram evidências de desenvolvimento de pensamento independente ou qualquer tipo de comportamento fora da programação.

- Todas as habilidades exibidas pelos modelos foram explicadas pela capacidade de seguir instruções, memorização e proficiência linguística, sem qualquer desvio.

- Em resumo, o resultado mostra que o medo de que um modelo de IA desenvolva comportamentos inesperados e consciência não é justificado.

O perigo real está nos humanos

Nos últimos anos, os modelos de linguagem (LLMs) evoluíram para se tornarem muito mais sofisticados, sendo capazes de manter conversas coerentes e naturais via texto. Apesar disso, esses modelos não são perfeitos, pois não possuem inteligência real, o que os impede de distinguir informações boas e ruins em muitos casos.

O perigo mesmo está em quem e como utiliza essas ferramentas. Ao contrário da IA, as pessoas são menos previsíveis, e seu uso desenfreado da tecnologia já levanta questões como direitos autorais, confiança, poluição digital e outros. Segundo pesquisadores, essas ameaças devem ser o foco de futuras investigações científicas.

Nossos resultados não significam que a IA não seja uma ameaça. Em vez disso, mostram que o suposto surgimento de habilidades de pensamento complexas associadas a ameaças específicas não é apoiado por evidências e que podemos controlar muito bem o processo de aprendizagem de LLMs, afinal.Iryna Gurevych, autora da pesquisa, em artigo da Universidade Técnica de Darmstadt

A pesquisa foi divulgada nos anais da 62ª Reunião Anual da Associação de Linguística Computacional.

Fonte: Olhar Digital