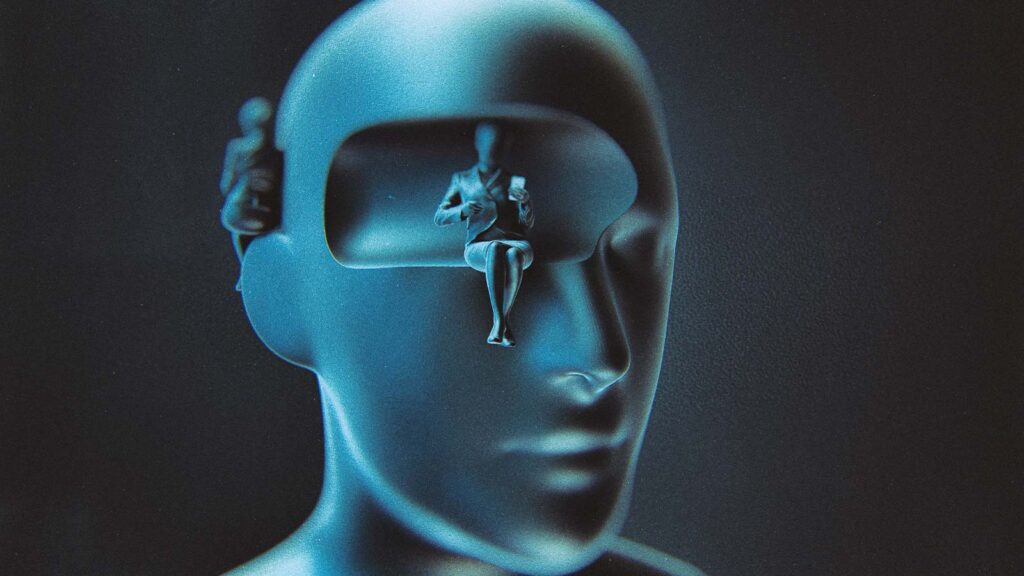

A verdade é que não sabemos como funcionam muitos de seus processos internos, o que torna a tecnologia inexplicável e, pior, imprevisível

Existem mentes alienígenas entre nós. Não são os homenzinhos verdes da ficção científica, mas as mentes alienígenas que alimentam o reconhecimento facial no seu smartphone, determinam seu limite de crédito e escrevem poesia e códigos de computador. Essas mentes alienígenas são sistemas de inteligência artificial, o fantasma cibernético com o qual nos deparamos diariamente.

No entanto, os sistemas de IA têm uma limitação significativa: grande parte de seu funcionamento interno é impenetrável, o que os torna, basicamente, inexplicáveis e imprevisíveis. Além disso, construir sistemas de IA que se comportem de maneira que as pessoas esperam é um desafio e tanto.

Se não conseguimos compreender algo tão imprevisível quanto a IA, como podemos confiar nela?

POR QUE ELA É IMPREVISÍVEL

A base da confiança é a previsibilidade. Ela depende da capacidade de antecipar o comportamento dos outros. Se você confia em alguém e essa pessoa não faz o que você espera, sua percepção da confiabilidade em relação a ela diminui.

Muitos sistemas de IA são construídos com base em redes neurais de aprendizado profundo (deep learning), que, de alguma forma, imitam o cérebro humano. Essas redes contêm “neurônios” interconectados com variáveis ou “parâmetros” que afetam a força das conexões entre os neurônios.

À medida que uma rede “novata” é apresentada a dados de treinamento, ela “aprende” a classificá-los ajustando esses parâmetros. Assim, o sistema de IA aprende a classificar dados que não conhecia antes. Ela não memoriza o que cada ponto de dados é: ela prevê o que um ponto de dados pode ser.

OS SISTEMAS DE IA TÊM UMA LIMITAÇÃO SIGNIFICATIVA – GRANDE PARTE DE SEU FUNCIONAMENTO INTERNO É IMPENETRÁVEL, O QUE OS TORNA, BASICAMENTE, INEXPLICÁVEIS E IMPREVISÍVEIS.

Muitos dos sistemas de IA mais poderosos contêm trilhões de parâmetros. É por isso que as razões pelas quais os sistemas de IA tomam as decisões que tomam são, muitas vezes, pouco transparentes. Esse é o problema de explicabilidade da tecnologia – a caixa preta impenetrável da tomada de decisão da IA.

Considere uma variação do “dilema do trem”. Imagine que você é um passageiro em um veículo autônomo controlado por IA. Uma criança pequena corre para a estrada e a IA agora precisa decidir: atropelar a criança ou desviar e bater, potencialmente ferindo os passageiros.

Essa escolha seria difícil para um ser humano tomar, mas temos a vantagem de poder explicar a decisão tomada. A racionalização – moldada por normas éticas, pela opinião de outras pessoas e por comportamentos esperados – sustenta a confiança.

Em contraste, uma IA não pode racionalizar sua tomada de decisão. Você não pode olhar sob o capô do veículo autônomo para ver seus trilhões de parâmetros e explicar por que ele tomou a decisão que tomou. A IA não atende aos requisitos prévios para inspirar confiança.

COMPORTAMENTO DA IA E EXPECTATIVAS HUMANAS

A confiança não se baseia apenas na previsibilidade, mas também em motivações normativas ou éticas. Normalmente, espera-se que as pessoas ajam não apenas como você presume que elas vão agir, mas também como deveriam agir. Os valores humanos são influenciados pela experiência comum e o pensamento moral é um processo dinâmico, moldado por padrões éticos e pela percepção dos outros.

Ao contrário dos seres humanos, a IA não ajusta seu comportamento com base em como é percebida pelos outros ou em normas éticas. A representação interna da IA do mundo é, em grande parte, estática, definida pelos dados com os quais foi treinada.

VOCÊ NÃO PODE OLHAR SOB O CAPÔ DE UM VEÍCULO AUTÔNOMO PARA VER SEUS TRILHÕES DE PARÂMETROS E EXPLICAR POR QUE ELE TOMOU A DECISÃO QUE TOMOU.

Seu processo de tomada de decisão é fundamentado em um modelo inalterável do mundo, sem se abalar pelas interações sociais dinâmicas e nuances que constantemente influenciam o comportamento humano. Pesquisadores estão trabalhando na programação de ética na IA, mas isso está se mostrando um desafio.

O cenário do carro autônomo ilustra bem o problema. Como você pode garantir que a IA do veículo tome decisões que estejam alinhadas com as expectativas humanas? Por exemplo, o carro poderia decidir que atingir a criança é a melhor solução, algo que a maioria dos motoristas humanos evitaria instintivamente. Essa questão do alinhamento da IA com nossas expectativas é outra fonte de incerteza que cria barreiras para a confiança.

SISTEMAS CRÍTICOS E CONFIANÇA NA IA

Uma maneira de reduzir a incerteza e aumentar a confiança é garantir que as pessoas participem das decisões tomadas por sistemas de IA. Essa é a abordagem adotada pelo Departamento de Defesa dos Estados Unidos, que exige que, para todas as decisões tomadas por IA, uma pessoa esteja ou no ciclo ou no controle.

No ciclo significa que o sistema de IA faz uma recomendação, mas um ser humano é necessário para iniciar a ação. No controle significa que, embora um sistema de IA possa iniciar uma ação por conta própria, um monitor humano pode interrompê-la ou modificá-la.

Embora manter os seres humanos envolvidos seja um ótimo primeiro passo, não estou convencido de que isso será sustentável a longo prazo. À medida que empresas e governos continuam a adotar essa tecnologia, o futuro provavelmente incluirá sistemas de IA embutidos, nos quais a tomada de decisões rápidas limita as oportunidades para as pessoas intervirem.

É importante resolver os problemas de explicabilidade e alinhamento antes que o ponto crítico seja alcançado, onde a intervenção humana se torna impossível. Nesse ponto, não haverá outra opção além de confiar na máquina.

PESQUISADORES ESTÃO TRABALHANDO NA PROGRAMAÇÃO DE ÉTICA NA IA, MAS ISSO ESTÁ SE MOSTRANDO UM DESAFIO.

Evitar esse limiar é especialmente importante porque a IA está sendo cada vez mais integrada em sistemas críticos, que incluem coisas como redes de energia elétrica, internet e sistemas militares.

Em sistemas críticos, a confiança é fundamental, e um comportamento indesejável pode ter consequências mortais. À medida que a integração da IA se torna mais complexa, torna-se ainda mais importante resolver os problemas que limitam a confiabilidade.

PODEREMOS ALGUM DIA CONFIAR NA IA?

Inteligência artificial é um tipo de alienígena – um sistema inteligente sobre o qual as pessoas têm pouca compreensão. Os seres humanos são, em sua maioria, previsíveis para outros seres humanos porque compartilhamos as mesmas experiências.

Mas isso não se estende à inteligência artificial, embora ela tenha sido criada por pessoas. Mais pesquisas nessa área, esperamos, lançarão luz sobre esse problema, garantindo que os sistemas de IA do futuro sejam dignos de nossa confiança.

Texto: Mark Bailey