A rápida popularização do ChatGPT pegou muita gente de surpresa. Já tendo milhões de usuários por dia, a ferramenta acabou fazendo com que diversas outras empresas lançassem soluções próprias, como o caso do Bard, do Google, e Ernie Bot, da Baidu.

Contudo, a proliferação destas plataformas de Inteligência Artificial (IA) tem gerado preocupações entre cientistas, pesquisadores e profissionais da área. A primeira questão pensada é o impacto ambiental que certamente será causado por estas novas tecnologias.

Em entrevista ao site Wired, Alan Woodward, que é professor de segurança cibernética da Universidade de Surrey, no Reino Unido, explicou que a indexação e busca de conteúdos na internet já gasta bastante poder de computação. O processo gera resultados como a queima de carbono, por exemplo, que aumentará com o uso cada vez mais maciço de IAs.

“Cada vez que vemos uma mudança no processamento online, vemos aumentos significativos nos recursos de energia [elétrica] e refrigeração necessários para grandes centros de processamento”, pontuou.

Carlos Gómez-Rodríguez, cientista da computação da Universidade de Coruña, na Espanha, explicou que somente empresas gigantes como Microsoft, Google e outras conseguem treinar os chamados grandes modelos de linguagem (LLMs).

Essa atividade de “ensinar” a IA a como responder às interações humanas envolve uma análise de uma gigantesca base de dados. De acordo com contas de analistas independentes, esse processo complexo pode ter feito com que o treinamento do GPT-3 (plataforma que dá base para o ChatGPT) tenha consumido cerca de 1.287 MWh e emitido mais de 550 toneladas equivalentes de dióxido de carbono.

“Não é tão ruim, mas você tem que levar em conta [o fato de] que você não só precisa treiná-lo, mas também executá-lo e atender a milhões de usuários”, acrescentou Gómez-Rodríguez para a Wired.

Maior escala

O treinamento de novos parâmetros (o ChatGPT só tem informações sobre o mundo real até 2021) e a escalabilidade das ferramentas para mais usuários é o que pode jogar o gasto energético e emissão de poluentes lá em cima.

“Se eles vão retreinar o modelo com frequência e adicionar mais parâmetros e outras coisas, é uma escala totalmente diferente de coisas”, afirmou Martin Bouchard, cofundador da empresa canadense de data center QScale, também em entrevista.

Bouchard defendeu ainda que os data centers atuais não dão conta das exigências destas atualizações e que, por causa disso, as empresas de tecnologia terão que aumentar as infraestruturas. Atualmente, os data centers já correspondem a cerca de 1% das emissões de gases de efeito estufa, segundo a Agência Internacional de Energia.

“Definitivamente não é tão ruim quanto o transporte ou a indústria têxtil”, diz Gómez-Rodríguez. “Mas a [IA] pode ser um contribuinte significativo para as emissões”, finalizou.

Nova escassez de GPUs?

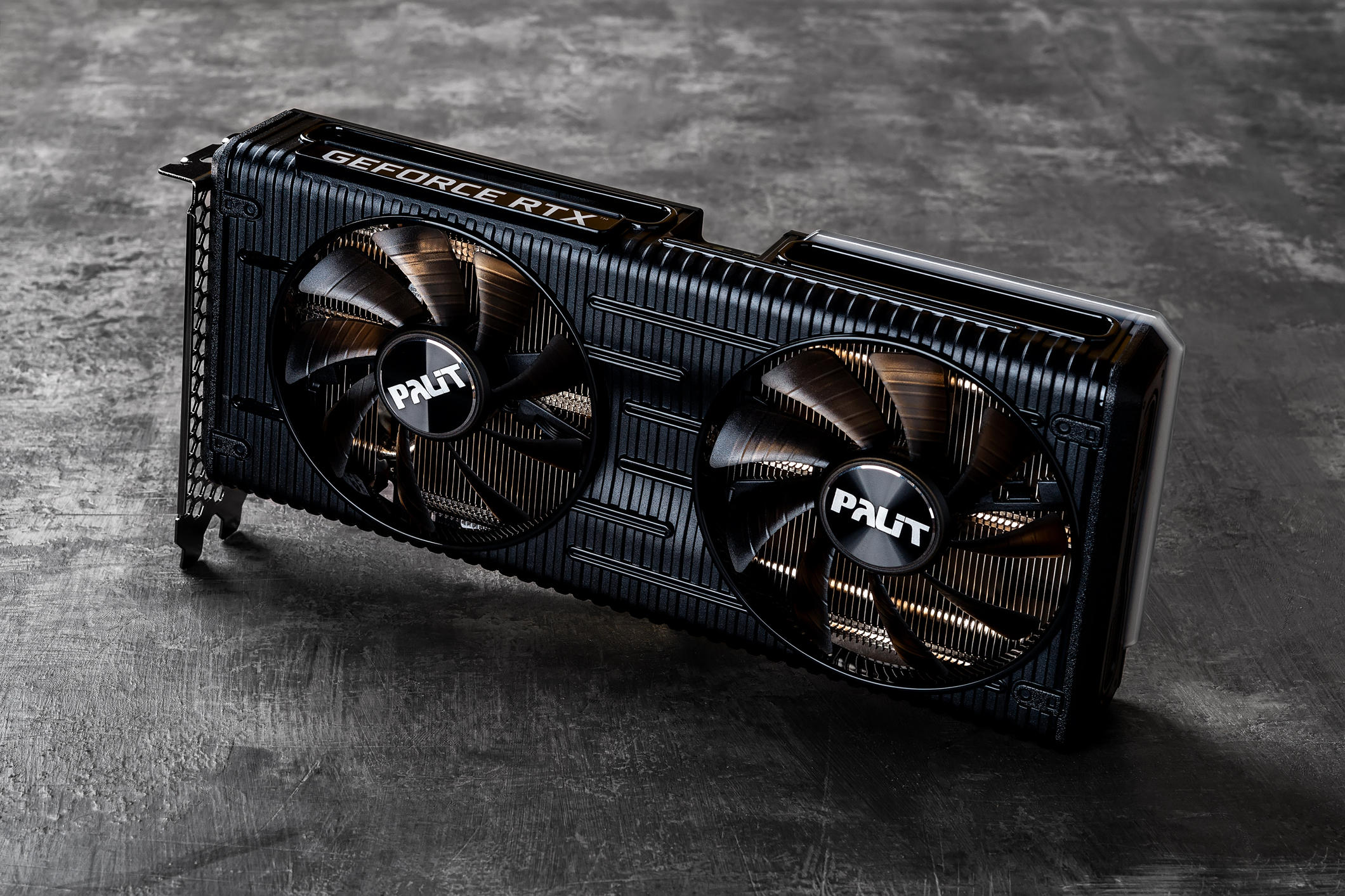

Além da enorme crise sanitária e de saúde, a pandemia de covid-19 impactou vários setores da economia. Um deles foi o mercado de tecnologia, que teve na escassez de GPUs um dos principais sintomas da mudança no comportamento das pessoas (que passaram a ficar muito mais tempo em casa e tiveram que comprar computadores, por exemplo).

A produção de GPUs caminha para a normalidade, já que medidas mais restritivas ficaram mais incomuns na maior parte dos países. Contudo, especialistas avaliam que a popularização das IAs pode trazer de volta o problema de escassez de placas de vídeo.

De acordo com uma estimativa realizada pela Forbes, integrar IA em cada pesquisa realizada no buscador do Google pode exigir a atividade de 4.102.568 GPUs Nvidia A100 e 512,820 servidores A100 HGX. O custo de todas estas placas seria nada menos que US$ 100 bilhões (cerca de R$ 522 bilhões).

Obviamente que esta movimentação não se dará deste jeito, já que a operação financeira é inviável. Contudo, a ideia aqui é que o treinamento dos “irmãos e primos” do ChatGPT, além dele próprio, tem o poder de causar um efeito inesperado na indústria de GPUs.

Fonte: Tec Mundo