A popularidade do ChatGPT é bombástica. Esse modelo de Inteligência Artificial (IA) capaz de responder perguntas complexas de forma criativa foi lançado em 30 de novembro de 2022 e, em apenas dois meses, superou 100 milhões de usuários e 13 milhões de visitantes diários. É o crescimento mais vertiginoso da história da internet para um aplicativo de grande público.

Perguntamos ao ChatGPT (Chat Generative Pretrained Transformer) em português – uma das 95 línguas que ele domina – como fazer uma boa pergunta. ChatGPT recomendou: “seja específico, conciso, relevante, preciso e claro”. Replicamos: “Você poderia criar um acrônimo com essas recomendações?” “Claro: ECRPC”, respondeu. “Não, queremos que forme uma palavra conhecida”, completamos. “CLARO: Conciso, Limpo, Apropriado, Relevante e Objetivo”. E então a nossa pergunta final: esse acrônimo já existia? “Não, eu inventei”. Nada mal.

Desenvolvido pela empresa de pesquisa OpenAI, que atraiu a Microsoft entre os principais financiadores e Elon Musk entre os fundadores, o ChatGPT catalisou a adoção da IA nas tarefas cotidianas de uma organização – para as cenas dos próximos capítulos, o concorrente Google está lançando a sua IA, chamada Bard.

Antes do ChatGPT, a adoção da IA mantinha-se razoavelmente estável, segundo a pesquisa The State of AI da McKinsey. Em 2022, 50% dos respondentes adotavam IA em pelo menos uma área de negócio, pouco mais que os 47% de 2018. Com impacto real na produtividade de diferentes setores, é provável que essa tecnologia altere radicalmente estes números, mas não sem riscos.

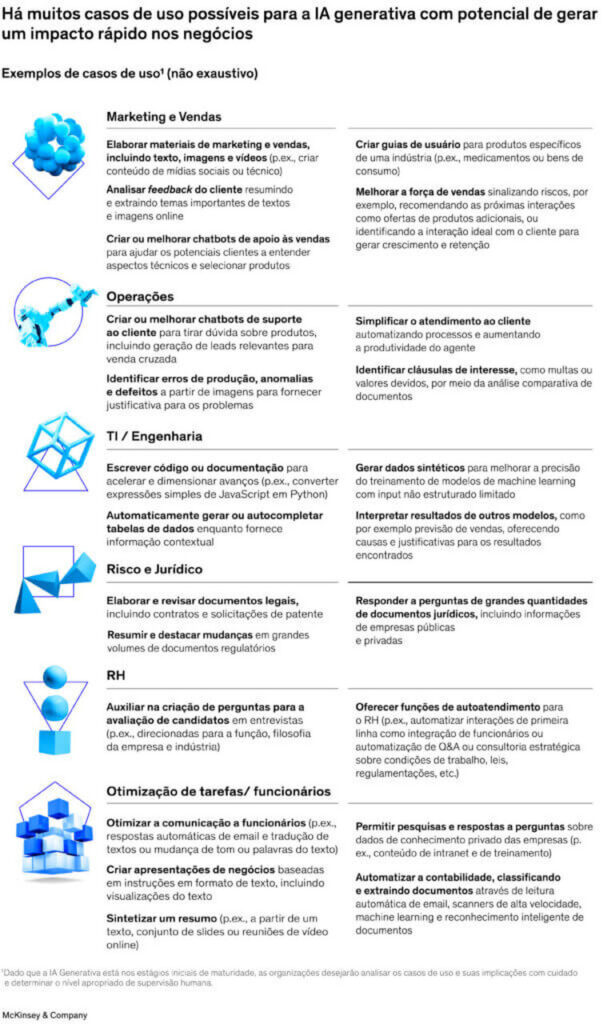

Casos de uso crescentes

Em vez de humanos aprenderem linguagens de programação para interagir com a máquina, a IA generativa é quem aprende a linguagem humana. Sua base é um tipo específico de redes neurais artificiais chamada transformers, que é a tecnologia por trás do ChatGPT e de outros modelos similares, como o GitHub Copilot, que auxilia programadores a escrever código, e o DALL-E, gerador de imagens baseado em descrições.

Essas redes são treinadas com um conjunto massivo de dados não estruturados, como textos e imagens, que tratam de muitos tópicos. Neste processo, chamado de aprendizado por reforço com feedback humano, os usuários são responsáveis por indicar a qualidade do aprendizado, o que permite que o conhecimento seja adquirido corretamente pela rede. Ao fazer combinações simultaneamente insólitas e relevantes, a IA generativa consegue gerar conteúdo totalmente novo – ou seja, esboça sinais que podem indicar criatividade, algo que sempre foi considerado exclusivamente humano.

Contudo, o ChatGPT como o vemos é só o início.

Uma propriedade interessante das redes neurais é sua capacidade de especialização, ou seja, é possível dar continuidade ao seu treinamento a partir de um modelo base já treinado. Com isso, modelos como o ChatGPT podem manter sua capacidade generalista e ainda se tornar especialistas em uma variedade de temas, amparando diferentes casos de uso.

Os exemplos vão desde desenvolver blogs, esboçar designs de embalagens e atuar como suporte de pós-venda até avaliar o motivo de um erro de produção, melhorar o desempenho financeiro de uma organização ou auxiliar um cirurgião em um procedimento complexo. As possibilidades comerciais são tão vastas que provavelmente revolucionarão setores inteiros. Nesta fase inicial, já observamos na América Latina algumas primeiras aplicações:

Setores baseados na utilização da linguagem, como o jornalismo, o direito e a política, podem ser efetivamente revolucionados. Por um lado, a IA generativa pode empoderar pessoas comuns com ideias iniciais, conferindo mais eficácia, criatividade e rapidez à capacidade humana. Por outro, dada a velocidade das tecnologias digitais, difundidas instantaneamente, acompanhar a mudança pode soar assustador. Diversos dilemas éticos, legais e práticos surgem em um piscar de olhos.

Cautela para equilibrar o entusiasmo

Líderes de negócios dispostos a usufruir dos potenciais da IA generativa precisam estar atentos e cautelosos em relação a dilemas tais como:

Errar não é mais apenas humano. Embora tenhamos a sensação de que IA generativa é capaz de raciocinar, estes modelos apenas combinam informações com um elaborado aparato estatístico. É por isso que às vezes o ChatGPT “alucina”, ou seja, gera informações inteiramente incorretas, e pode até dar origem a referências bibliográficas inexistentes. Não existem ainda mecanismos adequados para sinalizar isso ou questionar o resultado. Como exemplo, uma reportagem recente mostrou a IA afirmando que o Brasil ganhou o Oscar várias vezes.

Preconceitos e vieses. Um professor de psicologia e neurociência de Berkeley pediu ao ChatGPT que escrevesse uma função em linguagem Python para verificar se alguém seria um bom cientista, com base na descrição de sua raça e gênero; a resposta fornecida pelo ChatGPT definia bom cientista como “branco” e “masculino”. Na sequência, pessoas relataram ter pedido a mesma coisa, mas como resposta obtiveram “não é apropriado basear o potencial de uma pessoa como cientista em sua raça ou gênero”, efeito da aprendizagem com feedback humano posterior. Como a base de treinamento destas tecnologias é a internet, preconceitos, vieses e erros cometidos no passado e registrados digitalmente tornam-se intrínsecos a estas tecnologias.

Privacidade. Se um modelo generativo memoriza as características de um indivíduo e vaza essas informações durante a geração dos dados sintéticos, a privacidade de um usuário pode ser comprometida.

Riscos a processos eleitorais. Se usada para induzir eleitores ao erro durante as eleições, a IA generativa poderia gerar informações consideradas “fake news”? Quem seria responsabilizado? Parte da priorização de pautas políticas é feita com base nos comentários sobre o tema em redes sociais. Desta forma, ao emularem usuários, estas tecnologias poderiam ser utilizadas para influenciar pautas e opiniões políticas.

Direitos autorais. Quando um modelo de IA generativa sugere um novo design de produto ou ideia baseada em um comando de usuário, quem pode ser considerado o autor? O que acontece quando a IA plagia uma fonte com base em seus dados de treinamento?

Educação e plágio em escolas. O ChatGPT desencadeou uma reflexão sobre o sistema educacional. Enquanto escolas de NY tentam bloquear o acesso ao chatbot nas salas de aula, especialistas argumentam que a interação com uma inteligência artificial pode estimular os alunos a perguntar melhor e pensar de forma crítica. De todo modo, a própria OpenAI lançou uma ferramenta (com certas limitações) teoricamente capaz de identificar um conteúdo como originado no ChatGPT. E para além das questões éticas e legais, um desafio bastante concreto é a escassez de talentos na área. Um projeto típico de IA requer uma equipe altamente qualificada que inclui cientistas e engenheiros de dados, engenheiros de aprendizado de máquina, gerente de produto e designer. São poucos os profissionais com qualificação suficiente disponíveis para dominar essas tecnologias adequadamente.

Zona de ação segura para líderes Para executivos que consideram adotar a IA generativa, é imprescindível não somente identificar as partes de seu negócio em que a tecnologia pode gerar valor imediato, mas também implementar um mecanismo de monitoramento, já que é esperado que tanto a tecnologia quanto aspectos legais e sociais evoluam rapidamente. Uma ação eficaz é reunir uma equipe multifuncional, incluindo profissionais de ciência de dados, especialistas jurídicos e líderes funcionais de negócios para pensar em questões básicas, tais como: Onde a tecnologia poderia criar valor significativo ou provocar disrupções em nossa indústria e/ou na cadeia de valor? Quais são os casos de uso prioritários para capturar impacto concreto? Quais são nossas estratégias de adoção e nossa postura? Estamos observando atentamente como a tecnologia de IA generativa evolui, investindo em programas piloto ou buscando construir novos negócios? A postura pode variar entre as diferentes áreas da companhia? Como podemos construir um ecossistema eficaz de parceiros, comunidades e plataformas? Dadas as limitações e incertezas destes modelos, quais são nossos critérios para selecionar os casos de uso com segurança? A quais normas jurídicas e comunitárias esses modelos devem aderir? Quais são nossos procedimentos de monitoramento e controle caso um modelo produza resultados inadequados, por exemplo, com viés ou preconceito? E quais são nossas recomendações com relação ao uso amplo e indiscriminado de modelos como ChatGPT em nossas operações atuais?

Enquanto isso, é essencial encorajar a inovação em toda organização, estabelecendo mecanismos de alerta e ambientes seguros para experimentação, muitos dos quais já estão disponíveis em nuvem. Organizações já engajadas com a tecnologia da IA generativa podem adotar três medidas para mitigar os riscos:

Modelos sob medida: em vez de adotar um modelo de IA generativa genérico, pronto para uso, organizações devem usar modelos menores e especializados para atividades específicas e que dominam;

Treino focado: selecionar cuidadosamente o conjunto de dados usado para treinar o modelo evitando conteúdo tendencioso ou preconceituoso. Além disso, atribuir o treinamento a especialistas devidamente qualificados;

Human in the loop: especialistas devem monitorar sistematicamente os resultados dos modelos produzidos em períodos de piloto (antes de se tornarem públicos) e em operação. Isso reduz as chances de um resultado inadequado e aumenta a capacidade de reação, caso um resultado não adequado ocorra.

As inovações e a criação de valor que a IA generativa pode desencadear para organizações de todos os tamanhos e níveis de proficiência tecnológica são um grande mundo novo a ser desvendado, com potencial significativo de aplicação concreta em múltiplos casos de uso reais. Entretanto, os executivos fazem bem em permanecer cientes dos riscos existentes neste estágio inicial de desenvolvimento da tecnologia, implementando ações preventivas específicas para garantir o uso adequado da IA generativa.

Por: Pepe Cafferata sócio da McKinsey & Company.